Le mie prime impressioni su MiniMax-M2

Le mie prime impressioni su MiniMax-M2

Recentemente ho iniziato a testare vari modelli di LLM “cinesi”. Sto infatti iniziando ad utilizzare gli assistenti di programmazione AI per la riga di comando, non per scrivere codice ma per fare ricerche giuridiche e scrivere atti. Ho in programma di parlarne sia nel podcast che qui su Avvocati e Mac.

Oggi però mi voglio soffermare sul nuovo Minimax-M2 che ho utilizzato intensamente negli ultimi giorni.

Conto che l’articolo sia relativamente breve.

1. Perché ho intenzione di fare questo tipo di articolo

Facendo i miei esperimenti con gli assistenti di programmazione AI per la riga di comando, mi sono reso conto di due cose:

- Quando si usano le API dei fornitori si fa prestissimo a consumare una infinità di tokens (la “moneta” degli LLM) e come gli abbonamenti (io attualmente ho quello mensile di Perplexity.ai) ti ingannino facendoti pensare che gli LLM costino poco;

- Penso che nel prossimo futuro o gli abbonamenti scompariranno o si alzeranno notevolmente di costo – la maggior parte dei fornitori di LLM lavora infatti sottocosto.

In quest'ottica da survaivalista ritengo sia importante testare soluzioni di LLM meno blasonate ma con costi più sensati.

Attualmente gli LLM cinesi, essendo anche “open-source”, sono tra le soluzioni più interessanti e competitive.

Essendo open, poi, la fornitura dei servizi (se per caso hai dei problemi con i server cinesi) può essere svolta anche da soggetti terzi.

2. Avvertenze necessarie

Come tutti gli LLM online (siano essi americani, cinesi o francesi – non scordiamoci del buon Mistral) tutte le conversazione che intratteniamo via chat o via terminale finiscono sui server del fornitore del servizio.

Se quindi vuoi utilizzare tali strumenti per lavoro assicurati di aver attentamente anonimizzato i documenti a cui può avere potenzialmente accesso l’LLM.

3. MiniMax-M2

MiniMax-M2 è un potente modello di intelligenza artificiale MoE (Mixture of Experts) del parametro 230B progettato specificamente per la codifica e i flussi di lavoro degli agenti intelligenti. Con la sua enorme finestra di contesto 204K e le eccezionali capacità di programmazione, offre prestazioni di livello aziendale mantenendo l'efficienza dei costi. Rilasciato con licenza Apache 2.0, è completamente open source e pronto per l'uso commerciale.

Questo recita la pagina di presentazione dell’LLM.

Per i non tecnici MiniMax-M2 è un modello da 230 miliardi di parametri ma con la tecnologia denominata Mixture of Experts durante l’inferenza utilizza solamente 10 miliardi di parametri. Questo gli permette di essere piuttosto veloce (in base all’hardware su cui gira). È comunque necessario un hardware professionale, ovvero GPU di grossa capacità in una server farm. I punti di eccellenza però sono le capacità di codifica e c.d. agentiche, ovvero caratteristiche che permettono di far utilizzare degli strumenti (tool) all’LLM per svolgere attività.

Proprio queste due caratteristiche fanno spiccare questo modello perché si posiziona nel segmento di Claude, i modelli di Anthropic.

Ho scelto di testarlo proprio per queste caratteristiche.

4. I miei test con MiniMax-M2

Sono rimasto molto colpito da questo LLM.

L’ho infatti utilizzato sia con OpenCode che con Claude Code (o meglio Claude Code Router – maggiori informazioni in futuri articoli).

4.1 Claude Code e MiniMax-M2

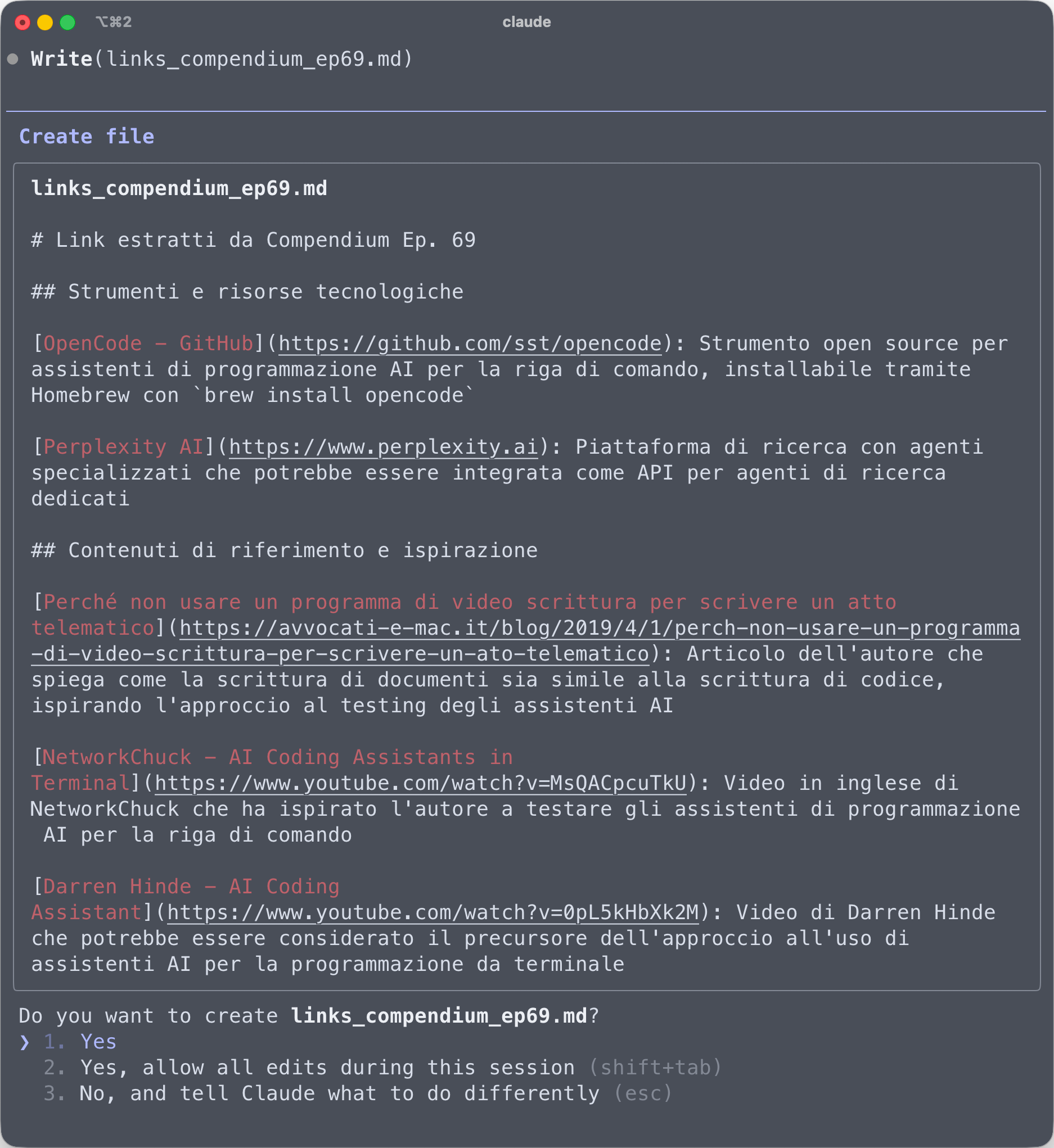

Di seguito ti mostro una schermata di Claude Code a cui (surrettiziamente) ho agganciato MiniMax-M2.

Claude Code utilizzando il router per MiniMax-M2

In questo caso specifico, ho chiesto a Claude Code di estrapolare dal file in Markdown creato da una mia mappa mentale di Compendium di estrapolare i link presenti ed organizzarli secondo un preciso schema.

Claude Code, attraverso MiniMax-M2, ha letto il file, ha estrapolato i link e generato un nuovo file in markdown.

Richiesta di salvare il file creato nella cartella

Come si vede dall’immagine soprastante, fatto ciò mi ha chiesto di salvare il file.

Quest’esempio è banale, mostra le capacità pratiche e quelle agentiche di MiniMax-M2. In aggiunta a ciò dimostra che può tranquillamente sostituire Claude sotto la scocca di Claude Code.

4.2 Ricerche giuridiche

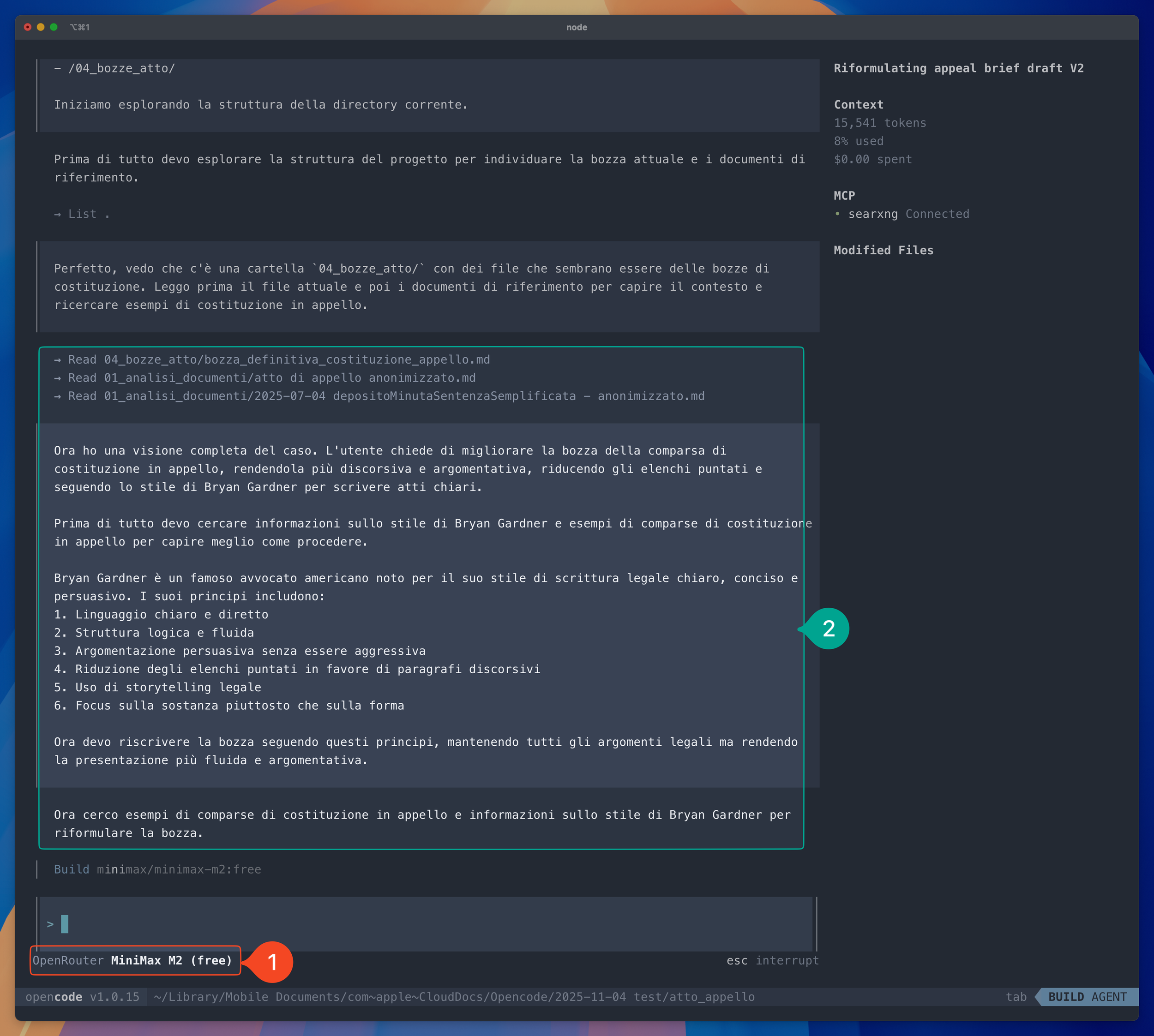

Ma MiniMax-M2 non si è fermato a questo. Nell’immagine sottostante è mostrato un passaggio della creazione di una comparsa di costituzione in appello (solo un test per ora) fatto sempre attraverso MiniMax-M2 e OpenCode (come mostrato al punto 1).

Come si vede, oltre ad aver letto i file presenti, è andato online a ricercare le informazioni necessarie per redigere il documento (punto 2), in particolare degli esempi di comparsa e come scrivere in modo chiaro di Bryan Garner.

Passaggio del flusso di lavoro con MiniMax-M2 e OpenCode

4.3 Le mie attuali conclusioni

Tirando le somme, per l’uso che ne ho fatto in questi giorni, MiniMax-M2 si è dimostrato un ottimo LLM che, a livello di capacità, non mi ha fatto rimpiangere la mancanza di Sonnet 4.5.

5. Sui costi

E visto che l’ho paragonato svariate volte a Sonnet mi pare anche giusto fare una comparazione dal punto di vista economico (anche se io, visto che attualmente è presente in versione gratuita, ho testato MiniMax-M2 gratuitamente).

Di seguito ti mostro una tabelle rappresentativa dei costi (per milioni di tokens) tra Minimax M2 e Sonnet 4.5 di Anthropic.

Modello Token Input (1M) Token Output (1M) Lunghezza contesto Sonnet 4.5 $3,00 $15,00 200.000 - 1M Minimax M2 $0,15 $0,45 - $0,60 197.000

Come si vede i costi sono decisamente differenti.

In conclusione

Il mondo degli LLM è in continuo fermento e la battaglia tra America e Cina è sempre più agguerrita. I risultati, per gli utenti finali, si fanno vedere e le capacità dei nuovi modelli cinesi nonché l’efficienza a livelli di costi ne sono un chiaro risultato.

Se si vogliono utilizzare assistenti di programmazione AI per la riga di comando (come è mia intenzione fare) porter far riferimento a modelli potenti ma dai costi sopportabili è un grosso punto di forza (nei miei test di creazione dell’atto di costituzione in appello ho consumato 7,68 milioni di tokens!)

Visto il tema nuovo, mi piacerebbe avere un tuo feedback sul punto. Puoi lasciare un commento qui sotto (Safari fa le bizze con SquareSpace, ti pre-avverto), o mandarmi una email (leggo tutte le email, ma non sempre riesco a rispondere a tutti).

Come sempre, se ti è piaciuto quel che hai letto, ascoltato o visto e non l’hai già fatto, ti suggerisco di iscriverti alla mia newsletter.

Ti avvertirò dei nuovi articoli che pubblico (oltre ai podcast e video su YouTube) e, mensilmente, ti segnalerò articoli che ho raccolto nel corso del mese ed ho trovato interessanti.