Scrittura “aumentata” con l’Intelligenza Artificiale

Recentemente mi sono imbattuto in questo articolo di Six Colors.

L’autore, John Birmingham, racconta come ha utilizzato Whisper e gli LLM per velocizzare la propria scrittura dettando il testo di un romanzo, facendolo “sbobinare” da Whisper e poi correggerlo e renderlo “presentabile” con un Modello Linguistico di grandi dimensioni (LLM).

Visto che il 10 Luglio 2025 devo tenere un intervento, come relatore, in un convegno a Reggio Calabria organizzato dall’A.N.F. locale e dall’Ordine ho voluto fare un rapido test di questa metodologia di lavoro.

1. Premessa: Aumentare la tua voce

L’approccio interessante di questo metodo ed il motivo per cui mi ha incuriosito è che utilizza i punti forti dei due sistemi di intelligenza artificiali utilizzati.

1.2 Whisper per convertire audio in testo

Whisper è un ottimo strumento per convertire l’audio in testo; oltre alla semplice “sbobinatura” il modello aggiunge la punteggiatura.

Personalmente, ormai da mesi, utilizzo Transcriber, l’app dell’amico Alex Raccuglia, per trascrivere tutte le puntate del mio podcast Compendium. La versione Large 3 funziona decisamente bene nel riconoscere il testo in italiano. Come sempre il riconoscimento del testo non è perfetto al 100%.

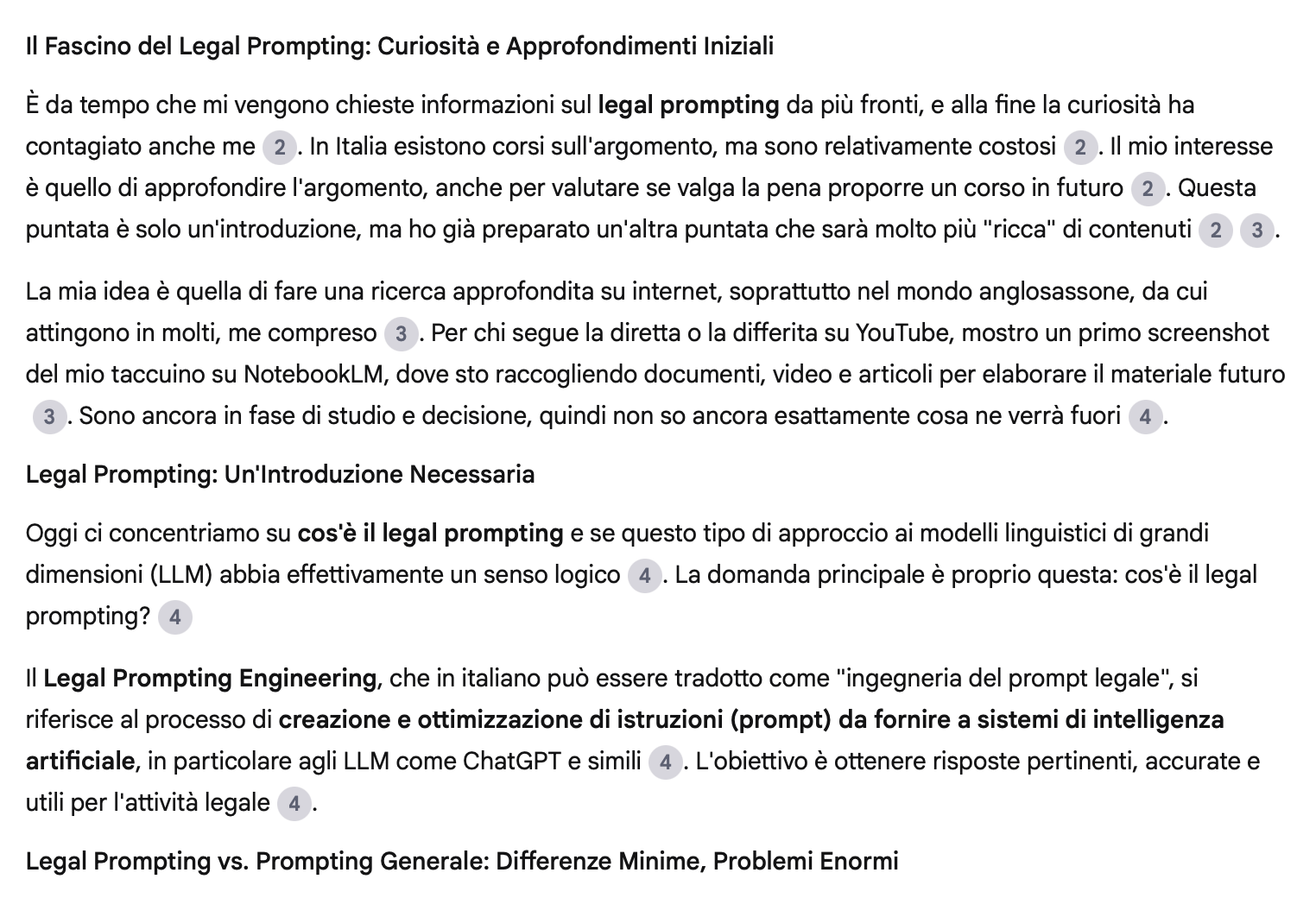

Nell’immagine che segue ti mostro la trascrizione della parte iniziale della puntata 56 di Compendium.

Esempio di testo trascritto dal file MP3 del mio podcast

1.3 LLM per creare una prima bozza

I Large Language Model (LLM) sono strumenti linguistici ottimi per revisionare e correggere un testo. In particolare se, invece di chiedergli di creare da zero un testo, gli passi un testo già creato le c.d. “allucinazioni” sono minime e, visto che gli LLM sono “esperti” dei linguaggi, sono anche ottimi strumenti per revisionare un testo; soprattutto un testo “parlato” che deve essere reso “leggibile”.

Utilizzando quindi questa capacità degli LLM è possibile passargli il testo della trascrizione e convertirlo in una prima bozza scritta.

Ovviamente il risultato sarà una prima bozza e poi dovrà essere revisionata ed ottimizzata con un lavoro manuale ed umano ma, per chi ama dettare, è sicuramente una manna dal cielo a livello di efficienza e relativa semplicità.

Esempio di come la trascrizione del podcast è stata “convertita” in articolo da Gemini

1.4 Aumentare la tua voce

Questo metodo, quindi, non demanda all’IA il ragionamento o la scrittura, è la tua voce ed il tuo pensiero lo scritto finale, ma utilizza l’IA per creare una prima bozza ben scritta (formalmente) e ti permette di dettare e ragionare a voce alta.

Tra l’altro registrare la propria voce oggi giorno è qualcosa di molto semplice visto che, a prescindere da personaggi – come il sottoscritto – che hanno la loro attrezzatura professionale per registrare la voce, tutti dispongono di uno smartphone e, così facendo, chiunque è in grado di registrare la propria voce.

2. Avvertenza 🚨

Io non ho mai usato in modo estensivo la dettatura vocale e, invece, amo scrivere con la tastiera, non ho quindi modo di testare in concreto questo metodo in un contesto legale; tuttavia, il modo più semplice che ho trovato per fare delle prove è stato usando le trascrizioni dei miei podcast, che già avevo sotto mano, e che, come vedrai nel proseguo dell’articolo, hanno dato risultati iniziali di buona qualità.

3. Trascrizione audio locale ed utilizzo di LLM online nel mondo legale

La cosa interessante di questo metodo è che Whisper funziona in locale (richiede o una scheda grafica dedicata, se sei su Windows o Linux, o un Apple Silicon se sei su Mac) ed è open-source.

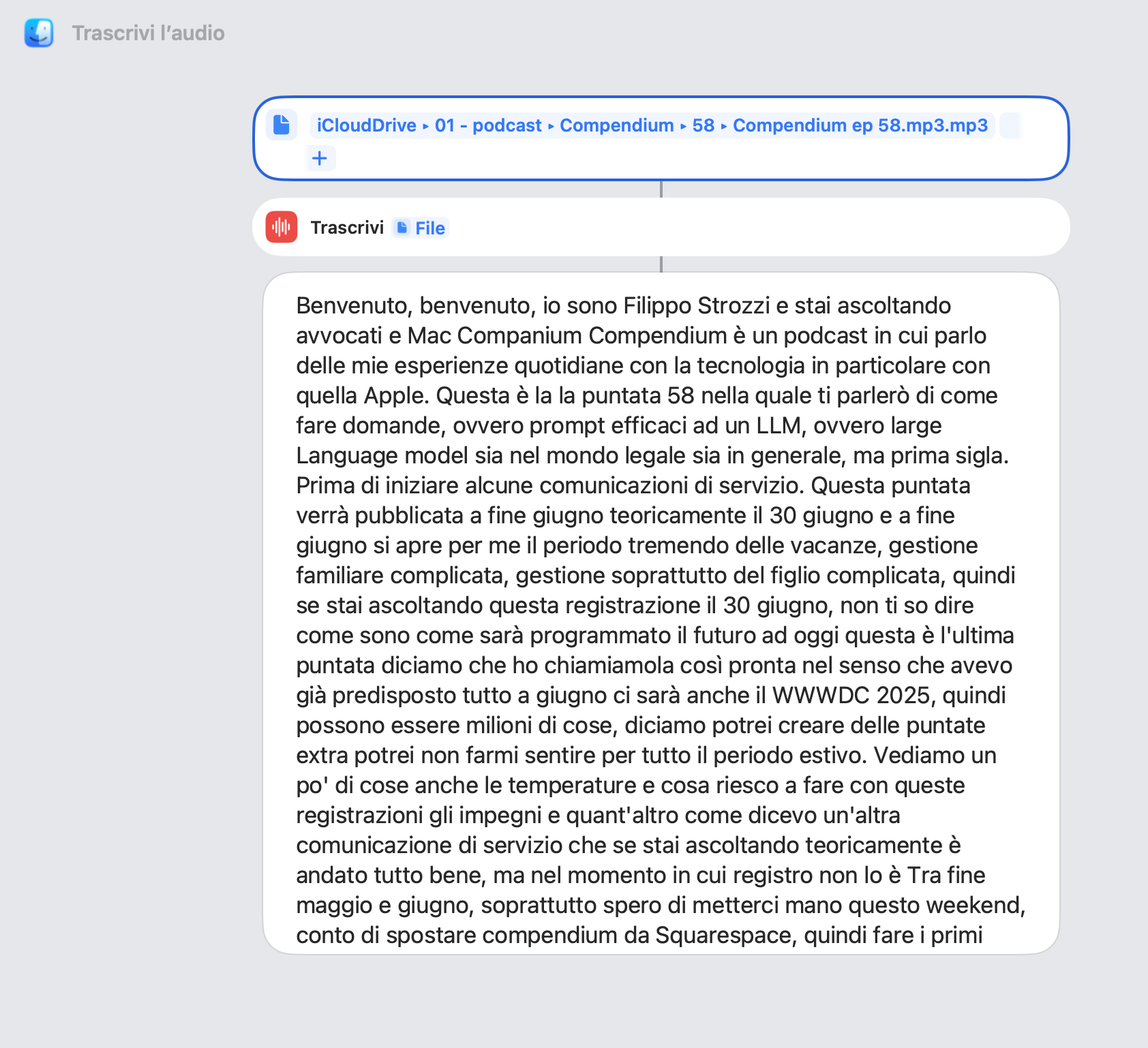

Per i temerari quindi è possibile scaricarlo e farlo andare a riga di comando. Per i meno temerari si può far affidamento su applicazioni a pagamento, come MacWhisper o Transcriber, o aspettare macOS 26 / iOS 26 / iPadOS 26 (presumibilmente a Settembre 2025), in cui, tra le varie cose, c’è un azione di Comandi Rapidi che esegue la trascrizione di un file audio.

Esempio di comando rapido su macOS 26 Tahoe di trascrizione di un mio podcast

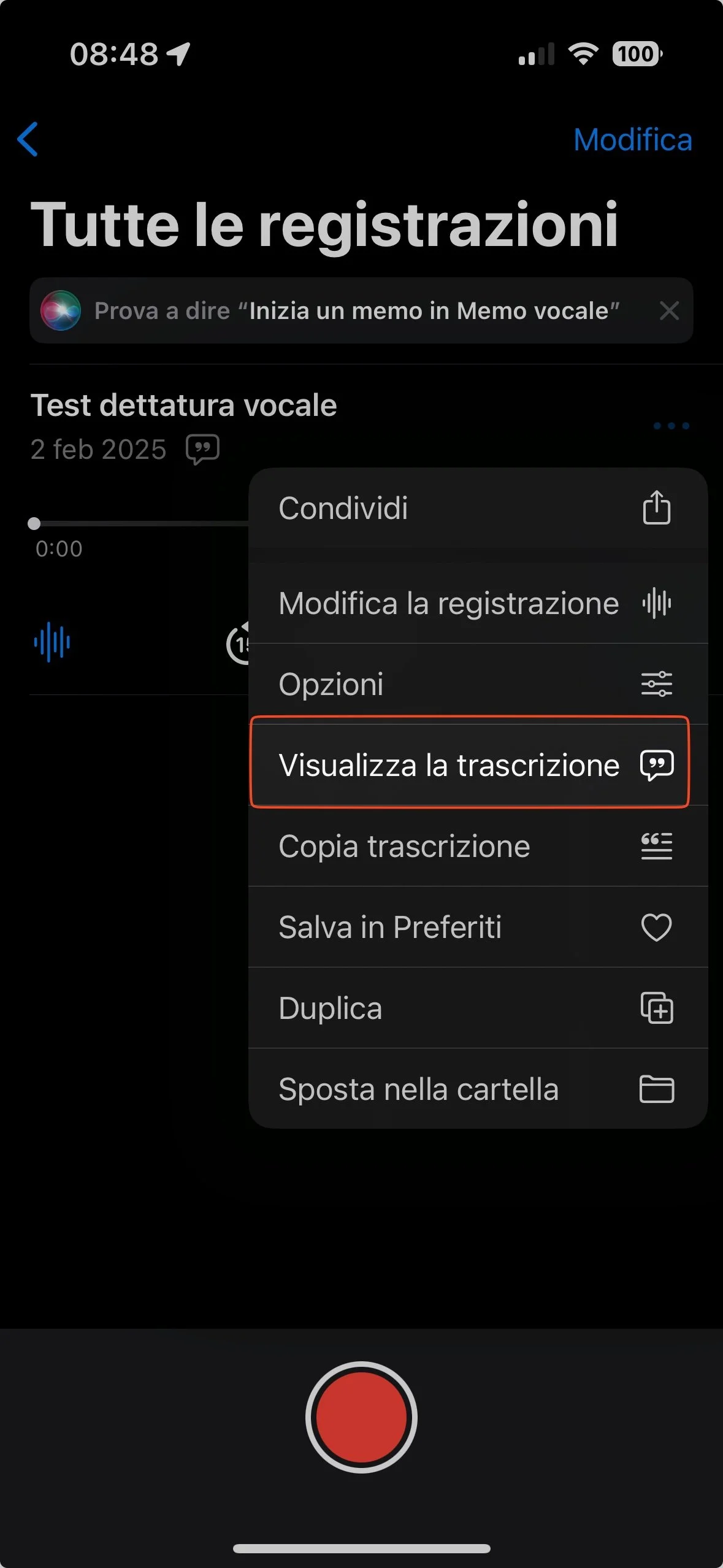

Opzione di trascrizione Memo Vocali sul mio iPhone 16 con Apple Intelligence

L’amico Roberto Marin mi ha fatto notare che, già su macOS Sequoia, è possibile trascrivere i Memo Vocali (attivando Apple Intelligence) così come su iOS 18 o iPadOS 18.

3.1 Metodi di revisione con IA

Quale che sia il metodo con cui hai fatto la trascrizione ora viene il momento di passarla ad un LLM.

Ho fatto vari esperimenti e ti suggerisco 2 differenti opzioni.

La prima, che vedremo in questo punto, è la soluzione che ho implementato subito ed a costo zero: utilizzare NotebookLM di Google.

Siccome avevo già caricato in NotebookLM le trascrizioni dei miei podcast, perché lo utilizzo per fare le sinossi di ogni puntata, mi è venuto facile fare i primi test con questa soluzione gratuita.

I vantaggi di questo strumento sono le enormi capacità di contesto (le puntate dei miei podcast sono lunghe dai 30 minuti all’ora) e la possibilità di generare grosse quantità di testo.

Giusto come metrica, la puntata 56 ha generato una trascrizione di circa 5.500 parole e, conseguentemente la conversione in “articolo” o testo scritto è arrivato a generare circa 5.200 parole.

Queste dimensioni richiedono l’utilizzo di LLM con grosse finestre di contesto (Gemini – l’LLM sotto la scocca di NotebookLM) riesce a gestire contesti di 1 milione di tokens (circa 600 mila parole).

3.2 Il prompt

Per i miei esperimenti iniziali ho copiato quanto proposto da John Birmingham approntando alcune (minime) modifiche. Non essendo l’audio stato registrato per essere convertito in un articolo ho dovuto aggiustare il tiro dell’LLM con il prompt.

Mi chiamo Filippo Strozzi. Ho registrato questo post sul blog usando un'intelligenza artificiale di riconoscimento vocale, quindi vaga un po' ed è pieno di errori di trascrizione e artefatti. Puoi ripulirlo mantenendoti il più vicino possibile al tono e al contenuto previsto? Formatta il documento in markdown, dividendo l’articolo in titoli e sottotitoli, seguendo il cambio degli argomenti. I titoli ed i sottotitoli devono essere intriganti e spiegare in modo chiaro il contenuto di quella sezione del testo.

In coda all’articolo trovi la trascrizione rielaborata da NotebookLM e, se vuoi, puoi confrontarla con l’audio della puntata che trovi qui.

3.3 Test con svariati LLM: il secondo metodo

Il secondo metodo è simile al primo ma con alcune variazioni.

Ho fatto ulteriori test (per curiosità intellettuale) sia con LLM locali che con altri LLM online.

In questi casi il modo più semplice è quello di inserire la trascrizione in un tag XML e poi aggiungere il prompt che ti ho mostrato sopra.

Il tag XML che abitualmente uso è il seguente:

<documento>

… testo che si vuole passare all’LLM …

</documento>Quella che ti ho mostrato, infatti, è la modalità più semplice per creare una sorta RAG fatta in casa senza componenti aggiuntivi (la RAG solitamente si usa per testi più lunghi da cui si estrapolano i passaggi rilevanti per la domanda).

Ovviamente in base al testo da revisionare occorre una finestra di contesto maggiore o minore. Per la trascrizione del podcast, purtroppo, i modelli locali che ho testato non davano buoni risultati.

Infatti abitualmente questi modelli restituiscono, nella migliore delle ipotesi, risposte tra le 500 e le 700 parole che, per testi lunghi non è sufficiente. Giusto solo come informazione: abitualmente vengono dette circa 100 parole al minuto quindi con gli LLM locali si possono ottenere revisioni soddisfacenti per registrazioni di massimo 5 minuti. Non molto direi …

Occorre, quindi, utilizzare LLM online. Io ho fatto qualche test e devo dire che non avuto buoni risultati con chatGPT 4o e Sonnet 3.5 mentre con Sonnet 3.7 e Gemini Flash 2.5 sì.

4. Suggerimenti per l’uso nel mondo legale

Ora, fino a questo punto, ti ho parlato di convertire un podcast in una sorta di articolo … ma per il mondo legale?

Sì, credo che una prima bozza sia realizzabile anche per il mondo legale; tuttavia ci vogliono alcune accortezze.

Anzitutto, posto che la prima stesura deve per forza di cose passare da LLM online ti suggerisco, se devi inserire dei nomi nell’atto che vuoi dettare, di utilizzare degli pseudonimi.

In particolare, posto che in ogni caso i cognomi o nomi di aziende non sempre vengono trascritti correttamente, ti consiglio di usare delle parole semplice come pseudonimi. Ad esempio potresti utilizzare: Lupo, Volpe, Orso, Tigre e Leone e segnando a parte le corrispondenze con i nomi reali.

Una volta che l’LLM ti restituirà la prima bozza potrai copiarla nel tuo programma di video scrittura o editing preferito e sostituire questi pseudonimi (che difficilmente comparirebbero in un atto legale) con i nomi reali delle parti utilizzando le basilari funzioni di trova e sostituisci nel testo, che qualsiasi programma di video scrittura possiede.

4.1 Dare indicazioni specifiche all’LLM per la formattazione del documento

Un’altra cosa da tenere presente è che, visto la particolarità del mondo legale, può venir comodo dare indicazioni specifiche all’LLM di come formattare correttamente una citazione giurisprudenziale o, caso molto frequente, la citazione di documenti.

Un possibile prompt parziale potrebbe essere questo: quando dico “documento 1” tu sostituiscilo con “(doc. 1).

Per pura curiosità, mentre finivo di scrivere questo articolo, ho “dettato” al microfono un mio atto e fatto qualche veloce esperimento. I risultati preliminare (e frettolosi) sono stati positivi ma non tali da condividerli qui.

5. Costi

A chiusura di tutto ti voglio segnalare che, anche a livello di costi, l’utilizzo di LLM online non è particolarmente dispendioso.

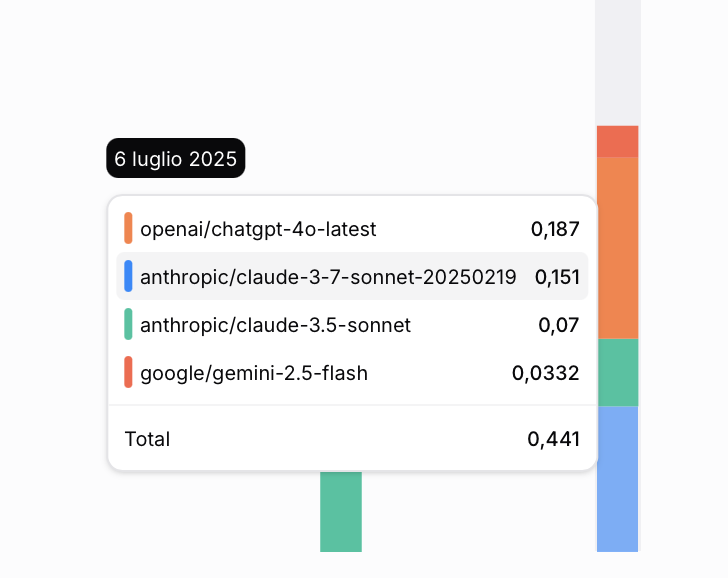

Se infatti utilizzando NotebookLM (allo stato) non ci sono spese (se si utilizza la versione gratuita) anche utilizzando LLM come Claude Sonnet o chatGPT i costi sono relativamente irrisori.

ChatGPT 4o, che mi ha dato i risultati peggiori, è stato il più costoso con 0,187 $.

Di seguito ti mostro i miei consumi in OpenRouter.

Esempio di costi per le 2/3 generazioni che ho fatto attraverso OpenRouter

OpenRouter è un interessante piattaforma che rivende servizi IA conto terzi e che mi permette di utilizzare differenti servizi solo per l’utilizzo che ne voglio fare, evitando i costosi (ed inutili) abbonamenti mensili a quel provider piuttosto che a quell’altro.

In conclusione

Quest’articolo è nato in modo abbastanza estemporaneo, l’ho scritto velocemente, ed in ragione di approfondimenti che ho fatto per una lezione che terrò / ho tenuto a Reggio Calabria.

Credo tuttavia che questo approccio sia molto promettente nel suo utilizzo generale così come nel più specifico ambito giuridico.

Personalmente sto ragionando di ottimizzare questo metodo ed implementare il sistema per poter proporre i contenuti audio e video che genero su differenti piattaforme riducendo in modo sensibile il tempo che devo dedicare alla conversione da un medium audio/video allo scritto.

Di seguito ti lascio il testo generato da NotebookLM della puntata 56. Più avanti conto di creare con questo metodo 2 articoli sul legal prompting, revisionando però la prima bozza generata dall’IA.

Il Legal Prompting Sotto la Lente

Benvenuto e benvenuta, sono Filippo Strozzi e stai ascoltando Avvocati e Mac Compendium. Compendium è un podcast in cui condivido le mie esperienze quotidiane con la tecnologia, in particolare quella Apple.

Questa è la puntata 56, nella quale ti parlerò delle mie prime approfondite ricerche sull'argomento del legal prompting. Oggi, non ci saranno comunicazioni di servizio, anche perché questa puntata è stata registrata con largo anticipo rispetto alla sua pubblicazione, presumibilmente intorno agli inizi di giugno.

Legal Prompting: Un'Indagine Necessaria

È da tempo che, da diverse parti, mi sono state richieste informazioni, e alla fine anch'io mi sono incuriosito su ciò che viene definito legal prompting. Dato che in Italia esistono alcuni corsi relativamente costosi, e poiché ero interessato ad approfondire l'argomento, anche per capire se valesse la pena proporre un corso in futuro, questa e le prossime puntate di Compendium saranno dedicate a questo tema, avendone già preparata un'altra che sarà più ricca di contenuti.

Oltre le Superfici: La Mia Ricerca sul Legal Prompting

Questa è una puntata introduttiva sull'argomento, ma la mia intenzione è quella di condurre una ricerca approfondita su internet, soprattutto nel mondo anglosassone, dove molte persone, inclusi io stesso, traggono abitualmente ispirazione. Per chi segue la diretta o la differita su YouTube, in questo momento sto mostrando un primo screenshot del mio taccuino su Notebook LM, dove sto progressivamente raccogliendo documenti, video, articoli e altro materiale, proprio per elaborare ciò che verrà.

Non so ancora cosa ne uscirà, sono ancora nella fase di studio e decisione. Oggi, in questa puntata, ci concentreremo su che cos'è il legal prompting e se questa tipologia di approccio al prompting per i Modelli Linguistici di Grandi Dimensioni (LLM) abbia effettivamente un senso logico.

Decodificare il Legal Prompting: L'Arte di Interrogare l'IA per il Diritto

La domanda principale è: che cos'è il legal prompting?

Legal prompting, o "Prompt Engineering Legale", si riferisce al processo di creazione e ottimizzazione di istruzioni, ovvero prompt, da fornire a sistemi di intelligenza artificiale, in particolare agli LLM come ChatGPT e altri simili, al fine di ottenere risposte pertinenti, accurate e utili per l'attività legale.

Al Confine tra Diritto e Intelligenza Artificiale: Peculiarità del Legal Prompting

Il primo interrogativo che mi sono posto è se il legal prompting abbia senso e quali differenze ci siano tra esso e il normale prompt engineering, che è sostanzialmente la stessa cosa, ma in un ambito più generico. Nella pratica, almeno dai miei approfondimenti, le regole dell'uno si applicano prevalentemente anche all'altro, quindi a mio parere le differenze sono effettivamente poche, se non l'aspetto specifico del dominio legale.

Il Gap tra Common Law e Civil Law: Una Sfida per gli LLM

Sull'aspetto specifico del dominio legale, lo ripeterò all'infinito: ci sono due problemi molto significativi. In primo luogo, gli LLM non conoscono il diritto civile italiano; anche se ci sono alcune differenze, ho notato, ad esempio, che Gemma3 di Google conosce qualcosa del diritto italiano, quindi parte del materiale di training ha incluso elementi del codice civile e di procedura civile italiano. Tuttavia, questa conoscenza è frammentaria, quindi è necessaria molta cautela. Il problema principale è che gli LLM non conoscono "di diritto" il nostro sistema, e se lo conoscono, è prevalentemente il diritto di Common Law, che è differente dal nostro (Civil Law). Sebbene alcuni istituti fondamentali siano simili in entrambi i sistemi, il Common Law si basa sul principio del precedente, mentre il Civil Law si fonda sul principio della norma e quindi del codice o della legge. Questa è già una problematica piuttosto rilevante.

Inoltre, gli LLM non comprendono il "legalese" italiano, e quindi una serie di parole e di linguaggio specifico del diritto legale italiano li confonde. Personalmente, ritengo che sia più utile imparare il cosiddetto legal prompting, ovvero in generale come formulare correttamente le domande agli LLM, piuttosto che intraprendere una formazione verticale specifica sul mondo legale. Ad oggi, non ho mai affrontato qualcosa di verticale sul mondo legale, eppure riesco a far funzionare abbastanza bene gli LLM. Ovviamente, si può sempre migliorare, ma la mia impressione personale attuale è questa: per fare un buon prompt engineering, e quindi anche un buon legal prompting, è necessario conoscere e capire come funzionano gli LLM.

L'Evoluzione Costante: Perché l'Aggiornamento è Fondamentale

Ritengo che sia fondamentale mettere mano all'informatica, perché finché non si inizia a interagire con questi sistemi, a capire come funzionano e a fare dei test, è impossibile imparare. Io ho giocato con questi sistemi per circa un anno e ora sto iniziando a ottenere risultati utili nel mondo del lavoro. L'altro aspetto è che questo settore è attualmente di grande attualità e, soprattutto, in continua evoluzione, quindi è essenziale tenersi sempre aggiornati. Ho acquistato un Mac Studio circa un anno fa, prima della Pasqua dell'anno scorso. Un anno fa, con il Mac Studio riuscivo a fare determinate cose; oggi, a distanza di un anno, con la stessa macchina e senza aver modificato nulla di significativo (forse ho imparato un paio di trucchi per ottimizzare, ma in percentuali irrisorie), il mio Mac Studio riesce a fare cose che un anno fa non era in grado di fare. Questo non perché io sia particolarmente bravo o perché il Mac Studio sia magicamente migliorato, ma perché i modelli open source che attualmente girano sul Mac Studio hanno capacità che prima non avevano, e tutto questo è avvenuto in un solo anno. Lo stesso vale, ovviamente, per i modelli online di grandi dimensioni, anzi forse a maggior ragione. Dal mio punto di vista, essendo questa una materia in piena evoluzione, il mio suggerimento è quello di adottare un approccio che definisco "olistico", che prediligo in questo frangente. Adesso analizzeremo le mie principali perplessità sull'argomento.

Il Dilemma della Riservatezza: Perché Usare LLM Online è Rischioso

Innanzitutto, ciò che ho notato nel panorama italiano e non solo, è che moltissimi utilizzano i modelli online per il legal prompting. Qui, a mio avviso, si presentano due problemi significativi. Il primo è legato alla riservatezza e alla segretezza dei documenti. Per rendere questi strumenti utili nel mondo legale, è ovvio che bisogna caricare i documenti e porre domande nelle chat di questi LLM. Il problema è che non si sa come vengano gestiti i dati che si caricano. Ti darò due esempi recentissimi di situazioni che mi lasciano perplesso (non perché le funzioni non siano interessanti, ma perché dimostrano quanto possa essere pericoloso fidarsi di questi soggetti e caricare documenti non nostri, ma dei clienti).

Chat GPT e la Memoria delle Conversazioni: Una Lama a Doppio Taglio

Il primo esempio è una cosa molto interessante che ha fatto Cloud for Education. In questo sistema, pensato per l'educazione, sono stati condotti studi anonimizzati delle chat per osservare come gli studenti (e non solo) utilizzano Cloud in ambito educativo. Questo, però, cosa significa? Significa che, a prescindere da tutto, hanno potuto estrapolare tutte le chat di una determinata fascia di soggetti, che hanno dovuto identificare in qualche modo, e le hanno potute analizzare statisticamente. Per fare ciò, ovviamente, significa che avevano accesso a tutte le chat. Anthropic ha dichiarato di averlo fatto in modo anonimizzato, ma la questione è sempre la stessa: non si sa sinceramente cosa possano fare e cosa facciano effettivamente questi sistemi, gestiti da soggetti terzi.

Una seconda novità, di cui ti parlo per rifletterci insieme, è la cosiddetta "memoria di Chat GPT". In sostanza, una delle nuove funzionalità introdotte a metà aprile 2025 da OpenAI è la possibilità per Chat GPT di conoscere le n chat precedenti avute, e quindi di fornire potenzialmente risposte più mirate, proprio in virtù del fatto che Chat GPT "conosce" le conversazioni passate. Queste conversazioni passate diventano una sorta di storico a cui Chat GPT può attingere per "conoscerti" meglio e fornirti maggiori informazioni su te stesso.

Probabilmente nella newsletter di questo mese ho incluso un articolo o un link a un articolo in cui uno scrittore ha interrogato Chat GPT su questo, e l'IA gli ha fornito i temi principali di cui l'autore aveva dialogato con essa. Questa è anche una funzionalità utile, ma d'altra parte è ovviamente anche inquietante. Ancora di più, se utilizzi questi strumenti per lavoro, quindi con materiale che dovrebbe essere riservato e segreto, possono sorgere dei problemi. Anche perché, come sempre, gli account non sono sicuri al 100%, e quindi potrebbe esserci chi accede con le tue credenziali e riesce, in maniera abbastanza semplice a questo punto, a conoscere di cosa hai parlato con Chat GPT nel passato, e quindi anche eventuali informazioni riservate dei clienti. In sintesi, il sistema dei modelli online è oggettivamente rischiosissimo per me. Infatti, come prassi, ho dato priorità all'utilizzo dei modelli offline.

L'Efficacia del Prompting: Online vs. Offline

Il secondo punto critico, almeno dal mio punto di vista, per l'utilizzo degli LLM online nel legal prompting, è che questi ultimi sono diventati relativamente intelligenti. Questo significa che, se è vero che con gli LLM locali utilizzare un prompt specifico e con determinate caratteristiche aiuta e può ottimizzare le risposte, per gli LLM online (come Chat GPT, Cloud, Gemini e così via), questa necessità si riduce, salvo un livello base di prompt engineering. Proprio perché questi strumenti, sia per i parametri molto elevati sia per i modelli addestrati con la "catena di pensiero", rielaborano in parte il prompt ricevuto e ragionano su di esso, abitualmente, a meno che non sia formulato un prompt completamente inefficace, non richiedono prompt particolarmente complicati.

Recentemente, ad esempio, mi interessava fare una cosa particolare, di cui parlerò nella puntata successiva a questa. Ho trovato online un prompt enorme, credo 20-25 righe, per realizzare l'operazione. Ho provato a utilizzarlo, ma non mi dava risultati eccellenti; l'ho semplificato molto e alla fine ho ottenuto il risultato desiderato. Nel mio caso specifico, era più un problema legato alla trascrizione del video e quindi la sintesi necessitava di una buona base dati, ma alla fine con un prompt di 3-4 righe dove ho specificato cosa volessi che facesse, Gemini non ha avuto problemi a darmi un buon risultato, o comunque il risultato che mi aspettavo. Ovviamente, come al solito, sono sempre necessari dei piccoli ritocchi; non si può prendere la risposta di un LLM e usarla direttamente.

Le Insidie dell'Intelligenza Artificiale nel Diritto: Allucinazioni e Mancanza di Conoscenza Specifica

L'altra considerazione è che, a mio parere, c'è un limite a ciò che si può fare con il semplice prompting, e vi sono svariati limiti. Il limite più grande è quello delle cosiddette allucinazioni. Ora, ci sono casi anche italiani di cronaca recente, come la sentenza del Tribunale delle Imprese di Firenze, dove un collega ha sostanzialmente redatto una memoria citando giurisprudenza inesistente, perché generata da Chat GPT. Una cosa simile era già capitata negli Stati Uniti, probabilmente circa un anno fa, il caso più noto è quello dell'avvocato di New York.

Le allucinazioni fanno parte del sistema: in sostanza, quando l'LLM non ha una risposta adeguata nella sua "conoscenza", genera testo. Genera testo in modo che la risposta sia verosimile, quindi la citazione sembra una citazione di una sentenza vera della Cassazione, ma poi, se la si verifica, non esiste, o peggio ancora, esiste ma non dice ciò che dovrebbe, perché l'IA se l'è inventato. Ricordo ancora, all'inizio, quando giocavamo, chiedevo informazioni su articoli di Avvocati e Mac, e mi forniva link a articoli che sapevo benissimo non esistevano, perché non li avevo mai scritti.

Questo è effettivamente uno dei grandi problemi, e l'altro problema significativo è che gli LLM non conoscono il diritto italiano, in particolare il linguaggio legale italiano. Per questo, dal mio punto di vista, qualsiasi attività legale seria necessita comunque di un intervento di RAG (Retrieval Augmented Generation). Tu fornisci all'LLM informazioni sul diritto italiano, sia direttamente nel prompt sia attraverso documenti veri e propri. Con il RAG, il livello di allucinazione diminuisce notevolmente, anche se non si elimina completamente. Una volta che hai "alimentato" l'IA con le informazioni necessarie, i risultati iniziano a essere abbastanza pertinenti, anche se è sempre necessario prestare attenzione e una revisione è sempre doverosa.

Il Ruolo Cruciale del RAG: Alimentare l'IA con la Conoscenza Giuridica

Giusto per farti un esempio, mentre cercavo, ho trovato vari articoli (che puoi trovare facilmente, anche perché non c'è molto sul legal prompting in italiano). Voglio presentarti un prompt che, pur essendo scritto bene, presenta un problema. Per chi sta guardando la diretta, la parte che mi interessa di più è quella in cui si specifica nel prompt cosa l'IA deve fare: "analizza attentamente il testo che ti fornirò, effettua una revisione completa che comprenda" e segue un elenco di cose. Nell'elenco c'è "segnalazione e correzione di eventuali criticità giuridiche, ad esempio riferimenti normativi errati, formulazioni giuridiche, lacune motivazionali". Sulle lacune motivazionali, forse l'LLM potrebbe anche arrivarci, ma sui riferimenti normativi errati e sulle formulazioni giuridiche, è evidente che se dai questo prompt in pasto a un modello come Chat GPT e simili, senza avergli fornito altre informazioni, il rischio che ti dia risultati non corretti è elevato proprio perché non conosce il diritto. Presumere che un LLM online conosca le criticità giuridiche è oggettivamente un grave azzardo, e i rischi che generi qualcosa di falso o non vero sono elevati.

Strumenti Professionali: Un Compromesso per l'Affidabilità

In secondo luogo, in questo caso specifico, l'obiettivo era una revisione di una costituzione di parte civile in un processo penale. Questo significa che la correzione a cui mirava questo prompt era di un atto giuridico. Presumibilmente, caricavi l'intero atto con i nomi delle parti e quant'altro, oppure dovresti caricare l'atto senza i nomi delle parti, anonimizzando tutto, facendo quindi un doppio lavoro per poi reintegrarlo. Questo è ovviamente un problema. Se io facessi una cosa del genere, personalmente avrei delle perplessità sul buon esito; anzi, una soluzione di questo tipo tende a portare a risultati negativi per quanto abbiamo detto prima.

Inoltre, poiché gli LLM non conoscono il diritto italiano ed è necessaria l'integrazione di RAG, in quest'ottica forse la via migliore è quella di cercare di utilizzare strumenti professionali. Strumenti professionali che, nella sostanza, non amo, proprio perché sono sistemi chiusi e quindi non sai esattamente cosa abbiano fatto e da quali basi dati stiano acquisendo le informazioni. Però, in questo caso, almeno hanno le banche dati giuridiche da cui estrapolano informazioni, e quindi tendenzialmente dovrebbero riuscire a fornirti risultati migliori.

I Modelli Linguistici Locali: Vantaggi di Sicurezza, Sfide Tecniche e di Costo

Infine, consideriamo anche questo: io sostengo molto l'utilizzo degli LLM locali. Gli LLM locali hanno una serie di vantaggi perché puoi fornirgli in pasto ciò che vuoi, ma non uscendo dalla tua rete internet e non stabilendo collegamenti online, non ci sono problemi relativi alla possibilità che i dati che fornisci all'LLM escano dal tuo ufficio.

Prestazioni e Finestra di Contesto: I Limiti dell'Hardware

I problemi sono vari, almeno dalla mia esperienza personale. Innanzitutto, la potenza di calcolo è limitata. Come ti dicevo, ho il mio Mac Studio con 32 GB di RAM, dotato di 24 GPU e così via. Sì, riesco a fare delle cose, anche in ambito legale, ma ho dei vincoli. E anche se, come ti dicevo all'inizio della puntata, questo computer nel complesso riesce a fare cose che un anno fa non riusciva a fare, ha comunque dei limiti notevoli che io conosco. Per restituirmi, ad esempio, una sintesi di una sentenza della Cassazione, i modelli buoni che mi danno ottimi risultati impiegano 3-4 minuti. Quindi, non è un'operazione così rapida. Ho mostrato in vari articoli le ricerche che ho fatto fare online a questi sistemi, e per ottenere una prima bozza di ricerca, hanno impiegato anche decine di minuti. Quindi, questo è un limite significativo.

Il secondo limite è la finestra di contesto. Ne abbiamo parlato nelle puntate precedenti, ma semplificando molto rapidamente, è la memoria operativa dell'LLM. Se posso dargli, per esempio, l'intero codice di procedura civile, difficilmente un LLM, soprattutto locale, riesce a caricarlo interamente nella memoria operativa e quindi a trovare tutte le norme di riferimento. Anche qui è necessaria una RAG. Sono riuscito a farlo perché ho caricato anche il codice civile all'interno di un LLM, e i risultati, come dicevo forse in puntate precedenti, non sono stati affatto male, anche se non ottimali. È però necessario utilizzare una RAG, e se voglio semplicemente fornire un blocco di testo da cui l'IA possa imparare a fare cose, comunque non riesco ad andare oltre i 10.000 token circa su questo computer che ha 32 GB di RAM. Ovviamente, più RAM si ha, più contesto si riesce a inserire, ma questo inizia a impattare sulle risorse hardware. E anche se utilizzo la tecnologia Apple, e anche se rispetto alla tecnologia dei PC normali ha un rapporto costo-prestazioni inferiore, un Mac Studio M4 base costa circa 4000 euro. Un Mac Studio M3 Ultra con 512 GB di RAM (quindi con un contesto considerevole e una quantità di credo 80 GPU) ha un costo intorno ai 12.000 euro. Quindi, sono investimenti che non sono alla portata di tutti e sono scarsamente abbordabili per molti.

Scalabilità e Competenze: Le Barriere all'Adozione Diffusa

Inoltre, l'altro grosso problema di queste soluzioni è la scalabilità. Finché ci sono solo io a utilizzare il mio Mac Studio (che ho pagato molto meno, comprandolo usato), o eventualmente un familiare o un collaboratore, e non effettuiamo ricerche contemporaneamente, allora ce la caviamo bene. Il cosiddetto "downtime", quando nessuno lo utilizza, è elevato e quindi è più probabile che non ci sia conflitto. Tuttavia, una macchina di questo genere in uno studio di 5-6-7-8 avvocati sarebbe limitata, proprio perché il rischio di fare ricerche in contemporanea e di bloccare le risorse è alto. Ovviamente, se una ricerca utilizza il 100% del sistema, chi vuole fare un'altra ricerca non ci riesce o viene rallentato a livelli notevoli.

Infine, l'ultima considerazione da fare è che, pur apprezzando molto tutta questa tecnologia, non è per tutti. Molte persone non hanno la volontà o il tempo di investire risorse per imparare, per "giocare", per valutare quale sia la soluzione migliore. Quindi, è necessaria una certa competenza tecnica. Ho imparato a utilizzare Docker, ho imparato a utilizzare una serie di sistemi; bisogna capire come funziona il sistema "sotto il cofano" altrimenti non si riesce a farlo.

Consulenze Professionali: Il Mio Supporto alla Digitalizzazione e all'AI nel Diritto

Un piccolo spazio che chiamiamo pubblicitario: recentemente un amico notaio mi ha chiesto una consulenza per approfondire l'utilizzo dell'intelligenza artificiale nella sua attività lavorativa, per chiarire i rischi, le potenzialità e, in generale, per non rimanere indietro. Se non lo sai, te lo dico: sono disponibile per consulenze sulla digitalizzazione e l'implementazione di IA negli studi professionali. Come sempre, la formazione di Avvocati e Mac sarà gratuita e aperta, come la stai ascoltando. Ma se sei interessato o hai necessità di approfondimenti specifici e personalizzati, puoi affidarmi una consulenza professionale per formazione uno-a-uno (per ora solo in videoconferenza) o per piccoli gruppi di persona, o per studiare ed elaborare flussi di lavoro ottimizzati per te. Nel caso, usa la mia email professionale, facilmente reperibile sia sull'albo online dell'Ordine degli Avvocati di Reggio Emilia a cui appartengo, sia direttamente sull'Albo Generale del CNF. Prima o poi, anche se è ancora presto, ho in programma di aggiungere un modulo specifico sul mio sito professionale, www.studialegaleastrozzi.it. Chiusa la parentesi pubblicitaria.

Il Senso del Legal Prompting e gli Strumenti per Iniziare

Il legal prompting ha sostanzialmente un suo senso logico, almeno da quanto ho analizzato io, per gli LLM locali. Ha senso perché gli LLM locali sono un po' meno sofisticati di quelli online, e inoltre permette di lavorare con documenti riservati o segreti dei propri clienti, ma ovviamente necessita di una RAG. Apro e chiudo una parentesi: ho parlato nella puntata 55 di strumenti per lavorare con Apple Silicon in maniera abbastanza semplice per tutti. Te li ricito, ma ti rimando alla puntata 55 per una descrizione più approfondita di cosa fanno e perché alcune cose mi piacciono e altre meno.

Strumenti Consigliati per Sfruttare l'AI sul Tuo Mac

I tre strumenti che consiglio, in ordine di difficoltà (dal meno difficile al più difficile/performante), sono:

- Misty: il primo, che in sostanza ti offre un ambiente unico e funzionale anche per fare RAG.

- NZing LLM: che non apprezzo tantissimo.

- LLM Studio: che ho dimenticato di inserire nella scheda, ma ora lo aggiungo.

- E infine, quello che utilizzo io (anche se non specificato, si intende il più avanzato tra quelli che permettono di operare in modo efficace).

L'Intelligenza Artificiale al Servizio del Legale: Applicazioni e Prospettive

Un'altra cosa da tenere ben presente, anche per valutare quanto valga la pena approfondire il legal prompting, è che la cosa più interessante nel mondo legale è la cosiddetta distillazione o riassunto. Ovvero, l'attività di fornire documenti agli LLM e ottenere un riassunto o persino estrapolare le informazioni rilevanti per l'utente, senza dover consultare un documento di grandi dimensioni. Anche qui, in base alla tipologia di documento, può valere la pena utilizzare strumenti online o offline. Gli LLM locali hanno comunque dei limiti sulla dimensione del documento, quindi se c'è molto testo è sicuramente meglio utilizzare gli LLM online, a meno che i documenti non siano riservati.

Abitualmente, se devo studiare una normativa particolarmente complessa o che si interfacci con altre normative, o addirittura normativa con articoli e giurisprudenza, utilizzo Notebook LM, ma comunque utilizzo un LLM online, sostanzialmente perché in quel caso posso fornire una quantità enorme di documenti, tanto non sono riservati e quindi non mi interessa caricarli. Anche lì, le domande che faccio sono più che altro legate all'estrapolazione di conoscenza da questi documenti. Invece, se devo analizzare documenti dei clienti, allora con i limiti del caso, utilizzando eventualmente il RAG, posso utilizzare gli LLM locali.

I documenti adatti agli LLM online, come dicevo, sono ad esempio:

- sentenze e provvedimenti giudiziari

- leggi o testi simili

- manuali e testi giuridici

- condizioni generali anche di contratti reperibili online (es. un contratto delle condizioni generali di una polizza assicurativa, solitamente un PDF di 30-40 pagine, può essere comodo scaricarlo e farlo elaborare all'LLM per le ricerche).

Dal Riassunto all'Albero Decisionale: Ottimizzare l'Analisi Documentale

Una cosa che pochi conoscono ma che, a mio avviso, è utilissima, e che anzi nella prossima puntata probabilmente andremo a vedere più in dettaglio, è la conversione in formati e strutture dati differenti. Questo sistema permette di fare cose anche relativamente avanzate. L'esempio che ti faccio oggi è quello di "predigerire" contenuti di documenti complessi. Nel caso specifico, ne parlerò più in dettaglio, ma questa è una cosa molto interessante secondo me: ciò che sto mostrando a video è il cosiddetto albero decisionale. In sostanza, ho fornito in pasto una sentenza della Cassazione all'LLM (credo fosse Notebook LM in questo caso, ma funziona sia in locale che online). Cosa succede? Richiedendo di generare un albero decisionale, l'LLM estrapola l'intero sistema e crea una specie di flowchart, cioè una rappresentazione grafica di ciò che è stato fatto in quella sentenza. Quindi, ti pone la domanda e ti fornisce informazioni utili, generalizzando da un certo punto di vista, ad esempio: "il decreto non si sofferma su questo scenario" o "valutare l'efficacia dell'effettiva esecuzione del rapporto di lavoro". Ti rimando all'immagine online che è ben visibile a schermo per spiegare il funzionamento di questi sistemi.

La possibilità di estrapolare informazioni da un documento e di strutturarle in varie maniere è notevole. L'albero decisionale è forse la cosa più avanzata, e infatti mi ha positivamente stupito nelle fonti che ho trovato. Un altro modo molto interessante di fare queste cose è, per esempio, quello di estrapolare informazioni e strutturarle come tabella, rendendo così il documento più facile da visualizzare.

Un altro argomento utile per il legal prompting è la ricerca giuridica, che può essere sia aumentata (ho tenuto un'Office Hour il 17 aprile 2025 proprio sull'argomento, dove ho mostrato quasi tutto, quindi non mi dilungherò ulteriormente) sia online. Nel senso che gli LLM possono essere impiegati online per condurre ricerche sul materiale presente su internet. Con dei limiti, in estrema sintesi, ma per esempio una prima bozza con eventuale ricerca delle fonti online, da approfondire in seguito, è molto utile. E anche qui, ti lascerò nelle note dell'episodio il link a un mio articolo su come fare specificamente queste cose.

Può essere interessante anche il discorso della revisione. Abbiamo visto all'inizio il prompt che presentava alcuni rischi. Ovviamente, con maggiori precauzioni in questi casi, personalmente negli atti giuridici utilizzerei gli LLM solo localmente. Se proprio si vogliono utilizzare gli LLM online, che effettivamente da un certo punto di vista sono più performanti, allora conviene fare quella che si chiama pseudonimizzazione dei documenti. Va bene caricare il documento come è stato scritto, ma si utilizzano sempre appellativi come "l'appellante", "l'appellato", "il ricorrente", "l'attore", "il convenuto", in modo che i dati non siano chiari. Anche qui, però, ci sarebbe sempre da fare un lavoro certosino di controllo, oppure si vanno a togliere tutti i nominativi e tutti i riferimenti che possono individuare i soggetti. Quindi, anche questa attività richiede, in questi termini, lavoro di preparazione. Estemporaneamente, si potrebbe immaginare di utilizzare gli LLM locali per cercare di anonimizzare un documento in automatico, per poi passare il testo anonimizzato all'LLM online e a quel punto farlo elaborare ulteriormente. Insomma, si possono anche individuare sistemi ibridi.

L'IA come "Cassa di Risonanza" e Strumento di Brainstorming

L'ultima cosa che ritengo molto utile, e su cui non molti riflettono, è quella di utilizzare l'LLM come una cassa di risonanza. Utilizzare l'LLM per ragionare sui documenti, per formulare ipotesi differenti anche di strategie, anche ipotesi negative (come dicevo nella mia Office Hour), o per valutare contro-argomenti. Questo perché, spesso, l'attività del legale è anche un'attività abbastanza solitaria; c'è poco modo e tempo di confrontarsi con altri. L'LLM, anche qui, personalmente utilizzerei un LLM locale, può avere un suo senso logico utilizzarlo come un assistente virtuale con cui confrontarsi. Non perché ci dia nuovi punti di vista, ma proprio per approfondire il nostro punto di vista e per avere un punto di vista "contrario", ottenendo così un risultato migliore.

Infine, anche per fare una sorta di brainstorming virtuale. Per esempio, uno dei modi, a mio parere, molto utili è quello di chiedergli di generare n ipotesi o n idee su un determinato argomento. In questo modo, magari se ne fanno generare 10 o 15. Raramente l'LLM ha spunti di intuito genuino, ma nella quantità c'è la possibilità che alcune di queste ipotesi ti permettano di avere quello spunto in più che poi ti consente di fare ulteriori ricerche, esperimenti e così via.

Legal Prompting: Una Strategia Integrata per il Futuro del Diritto

Siamo giunti alla fine. Come sempre, ti segnalo che il legal prompting è una delle strategie, a mio parere, da conoscere. Non è l'unica strategia, e fermarsi solo a quella è un po' limitante; anzi, rischia di darti una visione abbastanza errata di come utilizzare gli LLM. In una futura puntata, perché probabilmente ci sarà una puntata intermedia con un argomento totalmente differente (non posso parlare sempre e solo di intelligenza artificiale), approfondirò le regole di base del prompt engineering. Queste regole, a mio avviso, sono necessarie da conoscere e diventano utili nel quadro generale di tutto quello che ti ho raccontato fino ad adesso. Ovvero, inserendo il prompt engineering come una delle cose da sapere, uno dei "trucchi" da avere a portata di mano per gestire l'attività legale coadiuvata e "aumentata", come mi piace chiamarla, con l'intelligenza artificiale.

Resta Connesso con Avvocati e Mac

Come sempre, se ti è piaciuto quello che hai ascoltato, ti propongo di iscriverti alla newsletter. Ogni mese invio un link e il link ad articoli che ho trovato interessanti che ho raccolto nel corso del mese. Ti avviso per ogni nuovo podcast, ogni nuovo articolo o eventualmente video. Come sempre, qui trovi le note dell'episodio con tutti i link e riferimenti, inclusa la sinossi generata dall'intelligenza artificiale di questa puntata, sul sito https://www.avocati-e-mac.it/podcast/56. Alla prossima!