Assistenti IA a Riga di Comando nel Mondo Legale: Una Guida Pratica (OfficeHour)

Questo “articolo” è stato scritto utilizzando la trascrizione della OfficeHour e lievemente rivisto da me. La mia idea è quella di dare anche un articolo da leggere a chi non si vuole vedere l'oretta di OfficeHour. Buona lettura.

Se ti stai chiedendo come l'intelligenza artificiale possa davvero trasformare il tuo lavoro quotidiano da avvocato, lascia che ti introduca a un mondo che forse ancora non conosci: quello degli assistenti IA a riga di comando. In questo articolo ti mostro come utilizzare questi strumenti potenti per creare un flusso di lavoro che ti permetta di lavorare in modo più efficiente, organizzato e produttivo.

Gli assistenti IA a riga di comando rappresentano un'evoluzione importante rispetto alle semplici chat online che probabilmente già conosci. Non si tratta solo di fare domande e ricevere risposte: questi sistemi possono interagire direttamente con i tuoi file, ricordare il contesto dei tuoi progetti, e diventare veri e propri collaboratori digitali che ti aiutano a gestire attività complesse.

1. Cosa sono gli assistenti ia a riga di comando e perché dovresti usarli

Prima di addentrarci nei dettagli tecnici, è importante capire cosa intendiamo quando parliamo di "assistenti IA a riga di comando" e perché potrebbero fare la differenza nel tuo lavoro quotidiano.

Quando pensiamo all'intelligenza artificiale, la maggior parte di noi immagina interfacce web come ChatGPT o Claude: apri il browser, scrivi una domanda, ricevi una risposta. Questi strumenti sono certamente utili, ma hanno dei limiti significativi nel contesto professionale. Non possono accedere direttamente ai tuoi file, non mantengono memoria del tuo lavoro tra una sessione e l'altra, e soprattutto richiedono di caricare documenti su server esterni.

Gli assistenti IA a riga di comando funzionano in modo diverso. Si tratta di programmi che esegui direttamente sul tuo computer, attraverso il Terminale (quella finestra nera con il testo bianco che forse hai intravisto qualche volta sul tuo Mac). Questi strumenti possono leggere e scrivere file nella cartella in cui stai lavorando, ricordare conversazioni precedenti attraverso un sistema di sessioni (che vedremo oltre).

La capacità di questi sistemi di integrarsi completamente nel tuo flusso di lavoro, leggendo materiali di riferimento e scrivendo bozze direttamente nelle cartelle del tuo progetto, trasforma l'IA da semplice strumento di consultazione a vero e proprio assistente di studio.

2. Il Setup Iniziale: Installare e Configurare Gemini CLI

Partiamo dalle basi pratiche. Per utilizzare questi assistenti devi innanzitutto installarli sul tuo computer. In questo articolo mi concentro su Gemini CLI, lo strumento a riga di comando sviluppato da Google per interagire con i modelli Gemini. Ho scelto Gemini CLI per questa dimostrazione per due motivi principali:

- attualmente offre un taglio gratuito molto generoso, e

- supporta finestre di contesto enormi (fino a un milione di token), il che significa che può gestire contemporaneamente grandi quantità di documenti e informazioni.

L'installazione su Mac avviene attraverso Homebrew, un gestore di pacchetti che semplifica enormemente l'installazione di software da riga di comando. Se non hai ancora Homebrew installato, è il momento di farlo: è uno strumento indispensabile per chi vuole sfruttare appieno le potenzialità del proprio Mac.

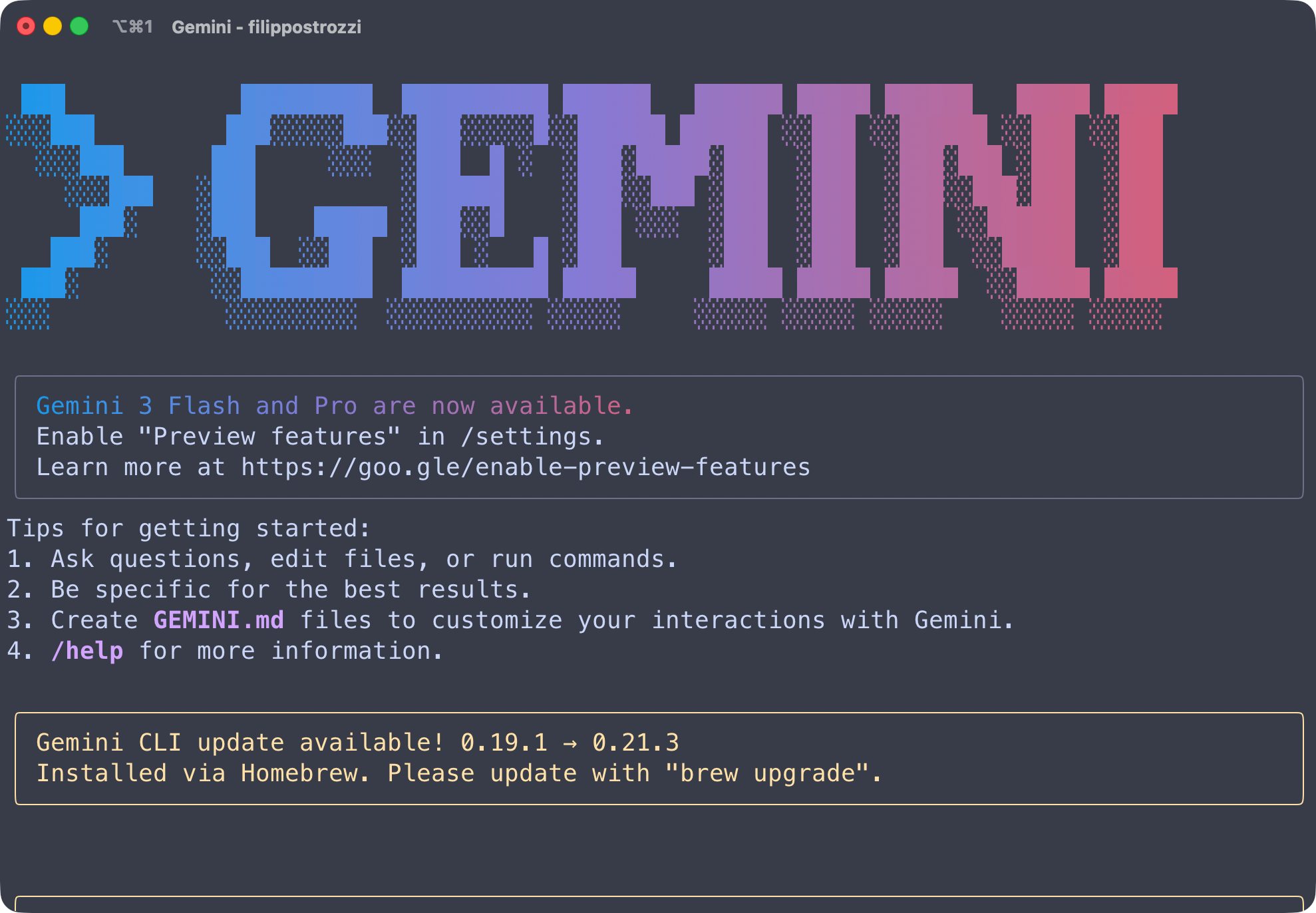

Una volta che hai Homebrew pronto, installare Gemini CLI è semplicissimo. Apri il Terminale e digita il comando brew install gemini-cli. Il sistema scaricherà e installerà tutto il necessario. Per verificare che l'installazione sia andata a buon fine, puoi semplicemente digitare gemini e premere invio: se tutto è andato come doveva, vedrai comparire l'interfaccia dell'assistente.

Un aspetto importante da considerare è che questi strumenti vengono aggiornati frequentemente, con nuove funzionalità e miglioramenti. Per aggiornare Gemini CLI alla versione più recente, utilizzi sempre Homebrew con il comando brew upgrade gemini-cli. Durante la dimostrazione che ho effettuato, per esempio, il sistema mi ha avvisato che era disponibile una nuova versione e l'ho aggiornata in tempo reale, passando dalla versione precedente alla 0.213, insieme all'aggiornamento di OpenCode da 164 a 169.

3. Lavorare in Modalità Sicura: La Sandbox

Una delle prime cose che devi configurare quando inizi a utilizzare Gemini CLI è la modalità di esecuzione. Per impostazione predefinita, questi assistenti potrebbero avere accesso a tutto il tuo sistema, il che rappresenta un rischio non indifferente. Immagina cosa potrebbe succedere se l'IA, interpretando male un comando, iniziasse a modificare o cancellare file importanti in altre cartelle del tuo computer.

Per questo motivo, Gemini CLI offre una modalità "sandbox" (letteralmente "scatola di sabbia"), che limita l'accesso dell'assistente alla sola cartella di lavoro in cui ti trovi. Quando avvii Gemini CLI con il flag -s, attivi questa protezione. Il comando completo diventa quindi gemini -s, e l'assistente ti informerà che sta utilizzando il sandbox di sistema (nel caso di macOS, fa riferimento al seabelt di Apple, il sistema di sicurezza integrato).

Questa precauzione è particolarmente importante nel contesto legale. Lavorando su cartelle di progetto specifiche, con la modalità sandbox attiva, puoi essere certo che l'IA non andrà a leggere o modificare documenti in altre parti del tuo sistema. È una barriera di sicurezza che ti permette di sperimentare e lavorare con maggiore tranquillità.

Prima di avviare l'assistente, assicurati sempre di trovarti nella cartella corretta. Nel Terminale, puoi spostarti tra le cartelle usando il comando cd (change directory). Un trucchetto molto utile su Mac è quello di digitare cd seguito da uno spazio, e poi trascinare la cartella desiderata dalla finestra del Finder direttamente nel Terminale con la proxy icon: il sistema inserirà automaticamente il percorso completo della cartella, evitandoti di doverlo digitare manualmente.

4. Il Cuore del Sistema: File di Configurazione e Contesto

La vera potenza degli assistenti IA a riga di comando emerge quando li configuri correttamente con system prompt che definiscono come devono comportarsi. Invece di dover spiegare ogni volta all'IA cosa deve fare e come, puoi creare un file di configurazione che viene letto automaticamente a ogni avvio.

Nel caso di Gemini CLI, questo file si chiama gemini.md e viene posizionato nella cartella di lavoro del tuo progetto. Si tratta di un semplice file markdown che contiene le istruzioni permanenti per l'assistente. Puoi pensarlo come a un "manuale di comportamento" che l'IA consulta prima di iniziare a lavorare.

Nel file di configurazione puoi specificare molti aspetti del funzionamento dell'assistente. Per esempio, puoi descrivere qual è l'obiettivo del progetto su cui stai lavorando, indicare dove si trovano i materiali di riferimento a cui l'IA dovrebbe attingere, definire lo stile di scrittura da utilizzare, e stabilire procedure specifiche per determinate attività. Nel mio caso, quando lavoro alla preparazione di un corso sull'intelligenza artificiale per avvocati, il file di configurazione contiene la descrizione del progetto, i riferimenti a tutte le cartelle con i materiali di studio, e le regole per gestire le sessioni di lavoro e la creazione delle todo list.

Una caratteristica fondamentale è che questo file deve essere sincronizzato tra diversi sistemi se vuoi mantenere coerenza. Per esempio, se utilizzi sia Gemini CLI che Claude Code, OpenCode o altri assistenti, dovrai avere copie identiche del file di configurazione (chiamate rispettivamente gemini.md, claude.md, agents.md) per garantire che tutti gli assistenti si comportino allo stesso modo. Nel mio workflow, ho configurato il sistema in modo che ogni volta che modifico uno di questi file, gli altri vengono automaticamente aggiornati dall’LLM di turno.

Il file di configurazione può essere scritto sia in italiano che in inglese. Personalmente preferisco l'inglese per le istruzioni tecniche, perché è la lingua "nativa" dei modelli linguistici e garantisce maggiore precisione nell'interpretazione. Tuttavia, per sezioni dove inserisco dialoghi o informazioni specifiche in italiano, non c'è problema: i modelli moderni gestiscono benissimo il code-switching tra lingue diverse.

5. Materiali di Riferimento: Costruire la Base di Conoscenza

Uno dei concetti più importanti quando lavori con assistenti IA a riga di comando è quello di "contesto". Come probabilmente sai già, altrimenti ne ho parlato in questo articolo e questo articolo, i modelli linguistici tendono ad "allucinare" quando non hanno informazioni sufficienti su un argomento, inventando di sana pianta sentenze, articoli di legge o riferimenti che non esistono.

La soluzione (parziale) a questo problema è fornire all'IA tutti i materiali necessari per lavorare correttamente. Questo approccio si chiama RAG (Retrieval Augmented Generation) e consiste nel dare all'intelligenza artificiale accesso a documenti specifici da cui può estrarre informazioni verificate invece di doverle generare dalla propria "memoria" pre-addestrata.

Nel contesto degli assistenti a riga di comando, implementare il RAG (una sorta di…) è sorprendentemente semplice: basta creare una cartella dedicata ai materiali di riferimento e indicarla nel file di configurazione. Nel mio workflow, ho una cartella chiamata "materiali di riferimento" che contiene decine di documenti: trascrizioni di podcast, articoli salvati dal web, video di YouTube convertiti in testo, ricerche effettuate con Perplexity, e materiale prodotto da me stesso.

Quando l'assistente riceve una richiesta, può automaticamente consultare tutti questi file per trovare informazioni pertinenti. Questo è particolarmente potente nel contesto legale. Immagina di avere una cartella con tutte le sentenze rilevanti per un certo tipo di causa, articoli dottrinali, e note preparatorie: l'assistente potrà attingere a tutto questo materiale verificato invece di rischiare di inventare riferimenti inesistenti.

La raccolta di questi materiali richiede tempo e organizzazione, ma è un investimento che ripaga enormemente. Nel mio caso, quando trovo un video interessante su YouTube riguardo un argomento che sto studiando, utilizzo l'intelligenza artificiale per estrarre la trascrizione e convertirla in un articolo strutturato in markdown. Questo articolo viene poi salvato nella cartella dei materiali di riferimento, diventando una fonte che l'assistente potrà consultare in futuro. Lo stesso vale per articoli web interessanti: usando strumenti come il web clipper di Obsidian, posso salvare rapidamente contenuti che poi diventeranno parte della base di conoscenza del progetto.

6. Il Sistema delle Sessioni: Memoria Persistente del Tuo Lavoro

Una delle differenze più significative tra lavorare con una chat web e utilizzare un assistente a riga di comando è il concetto di sessioni. Quando usi ChatGPT o strumenti simili, ogni conversazione è essenzialmente isolata: puoi tornare a una chat precedente, ma il contesto si perde progressivamente e devi spesso ripetere informazioni.

Gli assistenti IA a riga di comando risolvono questo problema attraverso le sessioni. Ogni volta che lavori con l'assistente, viene automaticamente creato un file di sessione che registra l'intera conversazione, le decisioni prese, e lo stato del progetto. Questi file vengono salvati nella cartella di lavoro, tipicamente in una sottocartella dedicata, con un nome che include la data.

La bellezza di questo sistema è che puoi interrompere il lavoro in qualsiasi momento e riprenderlo esattamente da dove l'avevi lasciato, anche giorni dopo. Quando riavvii l'assistente, il sistema legge automaticamente l'ultima sessione e "sa" esattamente a che punto eravate rimasti. Nel mio caso, ho configurato l'assistente in modo che alla semplice parola "ciao" vada a leggere l'ultima sessione, il file to-do del progetto, e mi dia un riassunto completo dello stato dei lavori con i prossimi passi da compiere.

Questo approccio risolve brillantemente uno dei problemi più comuni nel lavoro con l'IA: la perdita di contesto. Quando lavori su un progetto complesso per giorni o settimane, avere questa memoria persistente significa che l'assistente diventa veramente un collaboratore che "ricorda" tutto quello che avete fatto insieme. Non devi più preoccuparti di ricostruire il contesto ogni volta che riprendi a lavorare.

Le sessioni sono anche preziose come documentazione. Puoi sempre tornare indietro e rivedere esattamente cosa è stato discusso, quali decisioni sono state prese, e come il progetto è evoluto nel tempo. Questo è particolarmente utile nel contesto legale, dove la tracciabilità delle decisioni e del processo di lavoro può essere importante.

7. Gestione Automatica delle Attività: To-Do List e Workflow

Un altro aspetto rivoluzionario di questi sistemi è la capacità di gestire automaticamente le liste di attività da svolgere. Invece di dover mantenere manualmente un elenco di cose da fare, puoi delegare questo compito all'assistente stesso, che terrà traccia di cosa è stato completato e cosa resta da fare.

Nel mio workflow, ho un file chiamato todo.md che l'assistente aggiorna automaticamente. Questo file contiene tutte le attività relative al progetto, organizzate in modo strutturato. Quando completo una lezione o una sezione del corso, l'assistente segna automaticamente quell'elemento come completato. Quando emergono nuove attività da svolgere, vengono aggiunte alla lista.

La cosa interessante è che questo non è un semplice elenco statico. Il file to-do può contenere collegamenti ad altri file del progetto, note su cosa manca da fare per ogni attività, e persino suddivisioni in sottosezioni per attività più complesse. L'assistente può consultare questo file per capire autonomamente su cosa dovrebbe concentrarsi successivamente.

Questo sistema trasforma l'assistente IA in un vero project manager digitale. Invece di dovergli dire ogni volta cosa fare, lui sa già qual è il prossimo passo logico nel progetto. Tu mantieni il controllo strategico, decidendo quali attività devono avere priorità, ma la gestione operativa della lista e il tracciamento dello stato di avanzamento sono completamente automatizzati.

8. Workflow di Revisione: Il Metodo dell'Autocritica

Un aspetto fondamentale quando si lavora con l'intelligenza artificiale è non fidarsi mai ciecamente del primo output generato. I modelli linguistici, per quanto potenti, possono commettere errori, avere imprecisioni, o semplicemente non cogliere alcune sfumature importanti. Per questo motivo, ho implementato nel mio sistema un workflow di revisione automatica basato sul concetto di "adversarial self-critique" (autocritica avversariale).

Il principio è semplice ma efficace: dopo che l'assistente ha generato una prima bozza di contenuto, un secondo passaggio analizza criticamente quel contenuto cercando specificamente punti deboli, errori logici, informazioni mancanti o affermazioni che potrebbero essere imprecise. Questo secondo passaggio non è semplicemente una rilettura, ma un vero tentativo di confutare e migliorare quanto scritto.

Nel contesto del legal prompting, questo approccio ricorda molto il metodo che utilizziamo naturalmente quando prepariamo un atto: scriviamo la prima versione, poi la rileggiamo con occhio critico cercando di smontare i nostri stessi argomenti per verificarne la solidità. L'intelligenza artificiale può fare qualcosa di simile, ma in modo strutturato e sistematico.

Quando l'assistente completa una bozza, gli chiedo esplicitamente di assumere il ruolo di critico e di cercare problemi nel testo appena creato. In base ai risultati di questa analisi critica, viene generata una lista di modifiche da apportare, che l'assistente poi implementa producendo una versione migliorata del documento. Questo processo può anche essere iterato più volte se necessario.

Ho scoperto questa tecnica attraverso una ricerca su Twitter (ora X) e l'ho poi approfondita usando Perplexity. Il risultato è stato così interessante che l'ho integrato direttamente nel mio workflow standard. La qualità dei testi prodotti con questo metodo di doppia revisione è notevolmente superiore rispetto a quella che ottengo con una semplice generazione diretta.

9. Integrazione con Altri Strumenti: gli spazi di Perplexity

Gli assistenti IA a riga di comando non devono necessariamente lavorare in isolamento. Nel mio workflow, li integro strettamente con altri strumenti di intelligenza artificiale, in particolare Perplexity per le ricerche approfondite.

Perplexity è eccellente per fare ricerche su Internet con l'aiuto dell'IA, fornendo risposte con citazioni verificabili. Utilizzo gli spazi di Perplexity per creare ambienti di ricerca dedicati a specifici argomenti. Per esempio, ho uno Space dedicato alla preparazione del corso sull'intelligenza artificiale per avvocati, dove conduco tutte le ricerche preliminari su argomenti che devo approfondire.

Il workflow è questo: quando incontro un argomento che voglio esplorare meglio, apro il mio Space dedicato in Perplexity e faccio le domande necessarie. L'IA di Perplexity cerca informazioni su Internet, le organizza, e mi fornisce una sintesi con le fonti. A questo punto, applico anche qui la tecnica dell'autocritica: chiedo a Perplexity di criticare le proprie conclusioni e di cercare controargomentazioni. Questo secondo passaggio spesso rivela limiti o imprecisioni nella prima risposta.

Una volta completata la ricerca, salvo il risultato come documento markdown e lo inserisco nella cartella dei materiali di riferimento del mio progetto. Da quel momento, l'assistente a riga di comando potrà accedere a quelle informazioni ogni volta che lavoriamo insieme. In questo modo, creo un flusso continuo tra ricerca online (Perplexity), documentazione (file markdown), e produzione di contenuti (assistente IA a riga di comando).

Questo approccio ibrido sfrutta i punti di forza di ogni strumento: Perplexity eccelle nelle ricerche su Internet con citazioni verificabili, mentre gli assistenti a riga di comando sono superiori nel lavorare con file locali, mantenere il contesto, e produrre documenti strutturati. La chiave è farli collaborare attraverso un sistema di file condivisi.

10. Orari e Limiti: Ottimizzare l'Uso dei Servizi Gratuiti

Un aspetto pratico importante quando si utilizzano servizi IA gratuiti è comprenderne i limiti e ottimizzare l'utilizzo per evitare di incorrere in blocchi o rallentamenti. Nel caso di Gemini CLI con account gratuito, ho scoperto che ci sono momenti della giornata migliori di altri per lavorare.

I servizi di Google AI tendono ad avere meno carico durante le ore notturne negli Stati Uniti, che corrispondono alla mattina in Italia. Più specificamente, dalle 6:00 alle 13:00 ora italiana c'è generalmente meno traffico sui server, e questo si traduce in risposte più rapide e minori probabilità di incorrere in limitazioni di rate. Ho scelto di fare la dimostrazione in questa fascia oraria proprio per questo motivo.

Un altro elemento da considerare è che i limiti di utilizzo per gli account gratuiti si resettano giornalmente. Nel caso di Gemini, questo reset avviene alle 9:00 del mattino ora italiana. Questo significa che se hai esaurito i tuoi token giornalieri lavorando il giorno precedente, alle 9:00 del mattino successivo avrai di nuovo a disposizione la quota completa. Pianificare le attività più intensive tenendo conto di questo reset può fare la differenza tra poter completare un lavoro o doversi fermare a metà.

Durante la dimostrazione pratica che ho effettuato, ho incontrato proprio questo tipo di limite: dopo aver lavorato per un po' con il modello Gemini 3 Pro, il sistema mi ha avvisato che c'era alta richiesta e non poteva processare ulteriori richieste. In questi casi, ho due opzioni: o aspettare che il carico diminuisca, oppure passare a un modello diverso. Ho scelto la seconda strada, switchando da Gemini 3 Pro a Gemini 2.5 Pro, che è leggermente meno potente ma era disponibile.

Gemini CLI ti permette di cambiare modello facilmente attraverso i comandi slash. Digitando /model, puoi vedere tutti i modelli disponibili e selezionare quello che preferisci. Nel mio caso, ho accesso anche ai modelli sperimentali perché ho fatto richiesta specifica a Google per il programma di early access. Se utilizzi solo i modelli standard, potresti avere meno opzioni ma anche meno rischi di incorrere in limitazioni.

11. Comandi e Prompt Avanzati: Riferimenti ai File

Una delle funzionalità più potenti degli assistenti a riga di comando è la possibilità di fare riferimento diretto a file e cartelle nei tuoi prompt. Invece di dover copiare e incollare contenuti, puoi semplicemente indicare all'assistente dove trovare le informazioni che gli servono.

In Gemini CLI, questo si fa usando la chiocciola seguita dal nome del file o della cartella. Per esempio, se voglio che l'assistente analizzi tutti i materiali nella mia cartella di riferimento, scrivo @materiali di riferimento nel prompt. Il sistema caricherà automaticamente tutti i file in quella cartella (fino ai limiti di contesto del modello) e li userà per rispondere alla mia richiesta.

Questo meccanismo è incredibilmente pratico quando lavori su progetti complessi con molti documenti. Invece di dover dire all'assistente "vai a leggere questo file, poi quest'altro, poi quest'altro ancora", puoi semplicemente fare riferimento a una cartella intera. L'assistente leggerà tutto il contenuto disponibile e lo utilizzerà come base per il suo lavoro.

Nel mio caso, quando chiedo all'assistente di sviluppare una nuova lezione del corso, scrivo qualcosa come: "Sviluppa la lezione 5 usando i contenuti in @materiali riferimento". L'assistente andrà a leggere tutti i 40-50 file presenti in quella cartella, estrapolerà le informazioni rilevanti per la lezione 5, e genererà una prima bozza strutturata. Tutto questo senza che io debba specificare singolarmente quali file consultare.

Ovviamente, più materiale dai all'assistente, più tempo impiegherà a processarlo. Durante la mia dimostrazione, quando ho chiesto di analizzare l'intera cartella dei materiali di riferimento, l'operazione ha richiesto diversi minuti. Ma il risultato è stato una bozza che teneva conto di tutte le fonti disponibili, con riferimenti specifici a quali documenti erano stati consultati.

12. Il Paradigma del "Dirigere, Non Eseguire"

Tutto questo sistema si basa su un cambio di mentalità fondamentale nel modo in cui approcciamo il lavoro con l'intelligenza artificiale. Non si tratta più di "fare il lavoro" tu stesso, ma di "dirigere il lavoro" che l'IA esegue per tuo conto.

Questo concetto, che ho trovato in diverse ricerche e che ho integrato nel mio corso, è particolarmente rilevante per gli avvocati. Tradizionalmente, il nostro valore professionale è sempre stato legato alla capacità di eseguire personalmente attività specialistiche: scrivere atti, fare ricerche, analizzare documenti. Con l'avvento dell'intelligenza artificiale, parte di queste attività esecutive può essere delegata, e il nostro valore si sposta verso capacità di ordine superiore: definire la strategia, verificare la qualità del lavoro, esercitare il giudizio professionale.

Nel contesto degli assistenti a riga di comando, questo si traduce nel creare sistemi che lavorano autonomamente seguendo le tue indicazioni. Tu definisci l'obiettivo (nel file di configurazione), fornisci i materiali necessari (nella cartella di riferimento), imposti il workflow (attraverso le istruzioni per le sessioni), e poi lasci che l'assistente faccia il lavoro pesante di generazione della prima bozza.

Il tuo ruolo diventa quello di supervisore esperto: verifichi che i materiali di riferimento siano completi e accurati, controlli che le bozze generate siano corrette e pertinenti, e affini progressivamente il sistema attraverso feedback. Ma l'attività esecutiva di base - leggere decine di documenti, estrarre informazioni rilevanti, organizzarle in una struttura coerente, scrivere una prima bozza - la fa l'IA.

Questo non significa che il lavoro diventi più facile o che richieda meno competenza. Al contrario, dirigere efficacemente un assistente IA richiede una comprensione profonda sia del dominio legale sia del funzionamento dell'intelligenza artificiale. Devi sapere quali informazioni sono necessarie, come strutturare il contesto, come formulare richieste efficaci, e soprattutto come verificare criticamente gli output. Ma una volta che hai sviluppato queste competenze, la produttività aumenta in modo significativo.

13. Sicurezza e Riservatezza: Considerazioni Pratiche

Quando si parla di utilizzare intelligenza artificiale nel contesto legale, la questione della sicurezza e della riservatezza dei dati è assolutamente centrale. Gli assistenti IA a riga di comando offrono vantaggi significativi in questo senso rispetto alle soluzioni cloud, ma richiedono comunque attenzione e configurazione appropriata.

Quando l'assistente legge un file per rispondere a una domanda, il testo di quel file viene inviato all'API del servizio (Google nel caso di Gemini).

Tuttavia, è importante capire che anche con gli assistenti IA a riga di comando, se utilizzi modelli online (come Gemini, Claude, GPT) stai comunque inviando dati a server esterni. La differenza rispetto alle chat web è che hai controllo molto maggiore su cosa viene inviato e quando. Ma il rischio zero esiste solo con modelli completamente locali che tuttavia, mentre scrivo, non hanno le capacità sufficienti – a meno di avere computer dedicati che costano 10 se non centinaia di migliaia di euro.

Per questo motivo, quando lavori su materiale realmente riservato - atti che contengono dati sensibili dei clienti, strategie processuali, informazioni confidenziali - la best practice è anonimizzare completamente i documenti prima di farli processare da modelli online. L'anonimizzazione non significa semplicemente togliere i nomi: significa sostituire tutti i riferimenti identificativi con pseudonimi generici, e verificare che nessun elemento del testo permetta di risalire all'identità delle persone coinvolte.

Nel mio workflow, quando devo far analizzare un atto reale, utilizzo pseudonimi semplici come "Parte A", "Parte B", "Società X", e così via. L'intelligenza artificiale non ha bisogno dei nomi reali per analizzare la struttura logica di un atto o suggerire miglioramenti. Una volta ottenuta la bozza revisionata, posso facilmente sostituire gli pseudonimi con i nomi reali usando le funzioni di trova e sostituisci del mio editor di testo.

14. Costi e Sostenibilità del Sistema

Un aspetto che rende questi sistemi particolarmente attraenti è la sostenibilità economica. A differenza dei costosi abbonamenti a software specializzati per il mondo legale, gli assistenti a riga di comando possono essere utilizzati con costi molto contenuti o addirittura gratuitamente, almeno per volumi di lavoro moderati.

Gemini CLI, per esempio, offre un tier gratuito che per molti utilizzi professionali è più che sufficiente. Durante una sessione di lavoro di un'ora, come quella che ho documentato, ho consumato circa 2 milioni di token in input e generato 22.000 token in output. Tutto questo è rientrato nei limiti gratuiti, anche se ho dovuto gestire alcuni momenti di alta richiesta passando a modelli meno caricati.

Esiste anche la possibilità di utilizzare servizi come OpenRouter, che permettono di pagare solo per l'utilizzo effettivo senza abbonamenti mensili. In questo caso, i costi sono davvero minimi: una sessione di lavoro intensa può costare pochi centesimi di dollaro. Questo modello è particolarmente conveniente se l'utilizzo è sporadico o se vuoi testare diversi modelli senza impegnarti in abbonamenti multipli.

La vera spesa, se decidi di andare verso soluzioni completamente locali per massimizzare la privacy, è nell'hardware. Modelli locali potenti richiedono computer con molta RAM e buone capacità di calcolo. Un Mac Studio con configurazione adeguata può costare diverse migliaia di euro.

In conclusione

Gli assistenti IA a riga di comando rappresentano un'evoluzione significativa nel modo in cui possiamo utilizzare l'intelligenza artificiale nel lavoro legale. Rispetto alle semplici chat web, offrono controllo maggiore, integrazione più profonda con il tuo workflow, e capacità di mantenere contesto e memoria tra sessioni di lavoro. La curva di apprendimento iniziale può sembrare ripida, soprattutto se non hai familiarità con il Terminale e gli strumenti a riga di comando, ma l'investimento vale assolutamente la pena.

Inizia con esperimenti su progetti non critici, familiarizza con i concetti base, e progressivamente integra questi strumenti nel tuo lavoro quotidiano. Mantieni sempre un occhio critico sugli output generati, verifica attentamente i risultati, e non dimenticare mai le questioni di riservatezza quando lavori con dati sensibili. Ma se applicati correttamente, questi sistemi possono davvero trasformare la tua produttività e permetterti di concentrarti sugli aspetti più qualificanti del lavoro legale, delegando all'IA le attività esecutive ripetitive.

Come sempre, se ti è piaciuto quel che hai letto, ascoltato o visto e non l’hai già fatto, ti suggerisco di iscriverti alla mia newsletter.

Ti avvertirò dei nuovi articoli che pubblico (oltre ai podcast e video su YouTube) e, mensilmente, ti segnalerò articoli che ho raccolto nel corso del mese ed ho trovato interessanti.